Tag: SEO

Mitte der 1990er Jahre fingen die anstehenden Internet Suchmaschinen an, das frühe Web zu erfassen. Die Seitenbesitzer erkannten rasch den Wert einer nahmen Positionierung in den Ergebnissen und recht bald fand man Organisation, die sich auf die Aufbesserung spezialisierten.

In Anfängen passierte der Antritt oft zu der Transfer der URL der speziellen Seite bei der vielfältigen Suchmaschinen im Netz. Diese sendeten dann einen Webcrawler zur Kritische Auseinandersetzung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Internetpräsenz auf den Server der Suchseiten, wo ein 2. Computerprogramm, der allgemein so benannte Indexer, Informationen herauslas und katalogisierte (genannte Wörter, Links zu anderen Seiten).

Die frühen Versionen der Suchalgorithmen basierten auf Infos, die mithilfe der Webmaster selbst existieren werden, wie Meta-Elemente, oder durch Indexdateien in Internet Suchmaschinen wie ALIWEB. Meta-Elemente geben einen Überblick per Inhalt einer Seite, jedoch stellte sich bald hervor, dass die Benutzung er Details nicht zuverlässig war, da die Wahl der benutzten Schlagworte dank dem Webmaster eine ungenaue Vorführung des Seiteninhalts sonstige Verben hat. Ungenaue und unvollständige Daten in den Meta-Elementen konnten so irrelevante Unterseiten bei besonderen Benötigen listen.[2] Auch versuchten Seitenersteller verschiedene Attribute im Laufe des HTML-Codes einer Seite so zu manipulieren, dass die Seite stärker in den Ergebnissen gefunden wird.[3]

Da die frühen Suchmaschinen im WWW sehr auf Aspekte angewiesen waren, die allein in Fingern der Webmaster lagen, waren sie auch sehr unsicher für Missbrauch und Manipulationen im Ranking. Um tolle und relevantere Vergleichsergebnisse in den Resultaten zu bekommen, mussten sich die Unternhemer der Suchmaschinen im WWW an diese Ereignisse integrieren. Weil der Riesenerfolg einer Suchseiten davon zusammenhängt, wichtigste Suchergebnisse zu den inszenierten Suchbegriffen anzuzeigen, vermochten untaugliche Testergebnisse dazu führen, dass sich die Benutzer nach ähnlichen Wege bei dem Suche im Web umgucken. Die Erwiderung der Suchmaschinen fortbestand in komplexeren Algorithmen beim Platz, die Kriterien beinhalteten, die von Webmastern nicht oder nur schwer beeinflussbar waren. Larry Page und Sergey Brin gestalteten mit „Backrub“ – dem Urahn von Google – eine Suchseiten, die auf einem mathematischen Matching-Verfahren basierte, der mit Hilfe der Verlinkungsstruktur Seiten gewichtete und dies in den Rankingalgorithmus reingehen ließ. Auch übrige Search Engines bedeckt pro Folgezeit die Verlinkungsstruktur bspw. in Form der Linkpopularität in ihre Algorithmen mit ein.

Suchmaschinen

What’s Robots.txt & Find out how to Create Robots.txt File? | search engine optimisation tutorial

Meldung: The best way to create your Amazon product itemizing step-by-step – Straightforward search engine optimization & optimization tutorial 2022

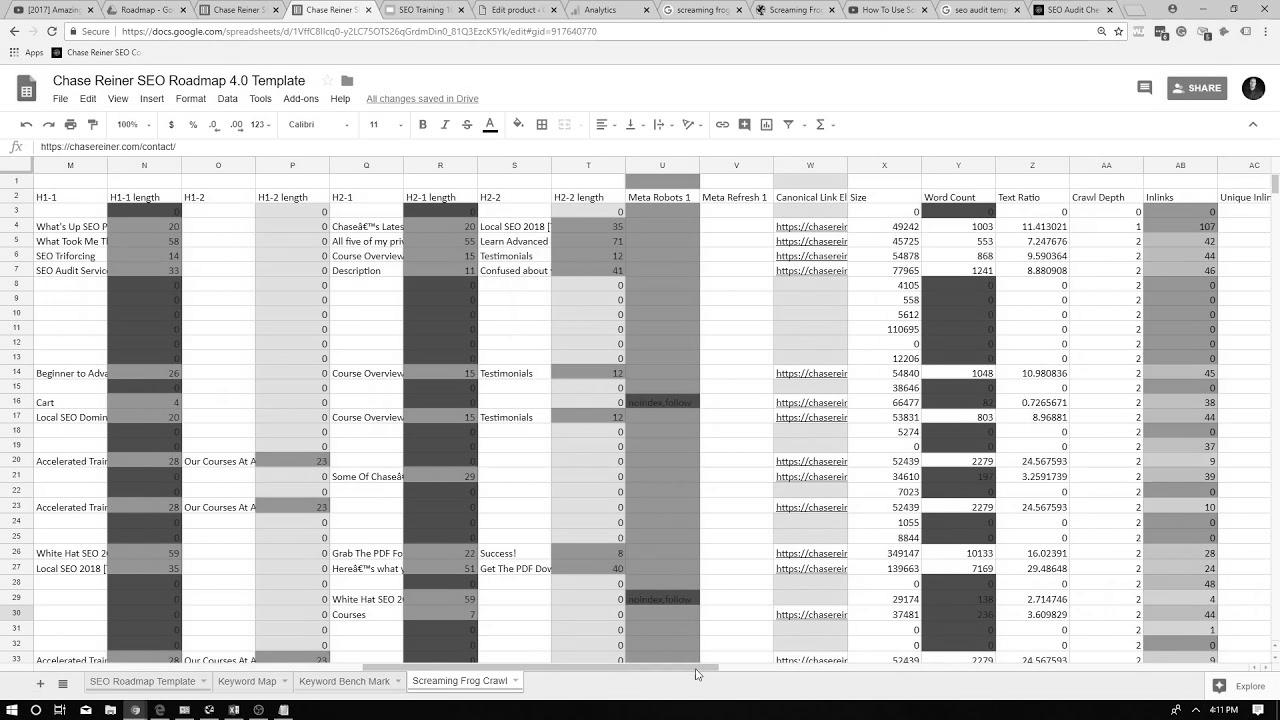

How To Create The Ultimate website positioning Audit (2018 Up to date)

Mehr zu: How to make BEST Thumbnails for YouTube Videos – SEO Search Engine Optimization Strategies

![Lawless Lawyer – EP13 | Lee Joon Gi & {Seo|Search engine optimization|Web optimization|Search engine marketing|Search engine optimisation|Website positioning} Ye Ji Make Up [Eng Sub] Lawless Lawyer – EP13 | Lee Joon Gi & {Seo|Search engine optimization|Web optimization|Search engine marketing|Search engine optimisation|Website positioning} Ye Ji Make Up [Eng Sub]](/wp-content/uploads/2022/06/1655091739_maxresdefault.jpg)

Lawless Lawyer – EP13 | Lee Joon Gi & Search engine optimization Ye Ji Make Up [Eng Sub]

How To Create Content material That Ranks Excessive In Search Engines – SPPC web optimization Tutorial #8

YouTube Marketing Course 2022 🔥 | Full YouTube search engine marketing Tutorial & Ideas

How can I make website positioning and Traffic Technology Simpler?

Key phrase Analysis for Ecommerce Web site/Online Store | Ecommerce search engine optimisation