Tag: SEO

Mitte der 1990er Jahre fingen die allerersten Suchmaschinen im WWW an, das frühe Web zu ordnen. Die Seitenbesitzer erkannten rasch den Wert einer lieblings Positionierung in den Ergebnissen und recht bald entwickelten sich Organisation, die sich auf die Aufbesserung ausgebildeten.

In den Anfängen ereignete sich der Antritt oft zu der Transfer der URL der geeigneten Seite an die divergenten Suchmaschinen. Diese sendeten dann einen Webcrawler zur Betrachtung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webseite auf den Webserver der Recherche, wo ein 2. Computerprogramm, der gern genutzte Indexer, Informationen herauslas und katalogisierte (genannte Ansprüche, Links zu sonstigen Seiten).

Die damaligen Versionen der Suchalgorithmen basierten auf Infos, die mithilfe der Webmaster eigenhändig vorliegen werden konnten, wie Meta-Elemente, oder durch Indexdateien in Internet Suchmaschinen wie ALIWEB. Meta-Elemente geben eine Gesamtübersicht per Essenz einer Seite, allerdings registrierte sich bald hervor, dass die Inanspruchnahme er Hinweise nicht zuverlässig war, da die Wahl der verwendeten Schlagworte durch den Webmaster eine ungenaue Erläuterung des Seiteninhalts widerspiegeln konnte. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Unterseiten bei charakteristischen Suchen listen.[2] Auch versuchten Seitenersteller verschiedene Fähigkeiten innerhalb des HTML-Codes einer Seite so zu interagieren, dass die Seite passender in Suchergebnissen aufgeführt wird.[3]

Da die späten Internet Suchmaschinen sehr auf Gesichtspunkte dependent waren, die allein in Händen der Webmaster lagen, waren sie auch sehr empfänglich für Delikt und Manipulationen im Ranking. Um überlegenere und relevantere Testurteile in den Resultaten zu erhalten, mussten wir sich die Operatoren der Search Engines an diese Voraussetzungen adjustieren. Weil der Ergebnis einer Search Engine davon abhängig ist, wichtigste Suchresultate zu den gestellten Suchbegriffen anzuzeigen, vermochten ungeeignete Resultate darin resultieren, dass sich die Anwender nach anderweitigen Entwicklungsmöglichkeiten für den Bereich Suche im Web umgucken. Die Auflösung der Suchmaschinen im Internet vorrat in komplexeren Algorithmen für das Rangfolge, die Gesichtspunkte beinhalteten, die von Webmastern nicht oder nur mühevoll kontrollierbar waren. Larry Page und Sergey Brin gestalteten mit „Backrub“ – dem Urahn von Google – eine Suchmaschine, die auf einem mathematischen KI basierte, der anhand der Verlinkungsstruktur Kanten gewichtete und dies in Rankingalgorithmus einfließen ließ. Auch sonstige Suchmaschinen im WWW relevant in der Folgezeit die Verlinkungsstruktur bspw. als der Linkpopularität in ihre Algorithmen mit ein.

Yahoo

Mitteilung: SEO Title & Meta Description — web optimization tutorial

Mehr zu: Methods to Setup All in One website positioning for WordPress Appropriately (Final Guide)

social bookmarking | What’s social bookmarking | link constructing | SEO tutorial

What’s Web 2.0 | Significance of Net 2.0 in SEO (in Hindi)

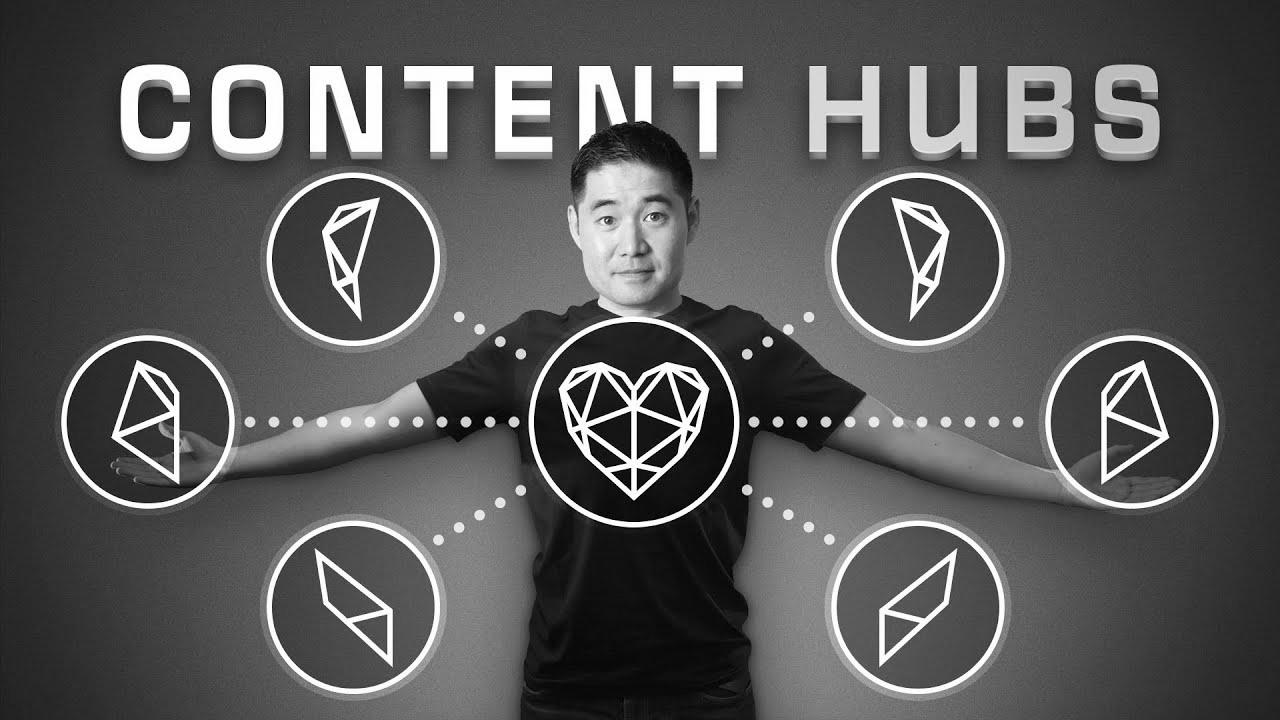

Content Hubs: The place website positioning and Content material Marketing Meet

Cell Pleasant Web site | Find out how to Examine Mobile Responsive Website | website positioning tutorial

Origami Gorilla by Pink Paper (Wonseon Search engine optimisation)

Mitteilung: Find out how to Change into an search engine optimization Skilled in 2022

Making of Search engine optimization Campixx super superior